–†–µ–Ї–Њ—А–і 10000

–†–µ–Ї–Њ—А–і 10000

–Ч–∞–Љ–µ—З–∞—В–µ–ї—М–љ–Њ–µ —Б–Њ–±—Л—В–Є–µ —Б–ї—Г—З–Є–ї–Њ—Б—М 26 –љ–Њ—П–±—А—П 2013 –≥–Њ–і–∞! –Ъ–Њ–ї–Є—З–µ—Б—В–≤–Њ –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є —Б–∞–є—В–∞ –≤–њ–µ—А–≤—Л–µ –њ—А–µ–Њ–і–Њ–ї–µ–ї–Њ –њ–Њ—А–Њ–≥ 10000 —З–µ–ї–Њ–≤–µ–Ї –≤ –і–µ–љ—М –Є —Б–Њ—Б—В–∞–≤–Є–ї–Њ 10144 —З–µ–ї–Њ–≤–µ–Ї! –Э–∞–њ–ї—Л–≤ –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є —Б–Њ–њ—А–Њ–≤–Њ–ґ–і–∞–ї—Б—П –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ—Л–Љ —А–Њ—Б—В–Њ–Љ –≥–ї—Г–±–Є–љ—Л –њ—А–Њ—Б–Љ–Њ—В—А–∞ –і–Њ 1,90, —З—В–Њ –≤ —Б–≤–Њ—О –Њ—З–µ—А–µ–і—М –≤—Л–Ј–≤–∞–ї–Њ –µ—Й—С –±–Њ–ї—М—И–Є–є –њ—А–Є—А–Њ—Б—В —З–Є—Б–ї–∞ –њ—А–Њ—Б–Љ–Њ—В—А–Њ–≤ - –і–Њ 19248, —З—В–Њ –њ–Њ—З—В–Є –љ–∞ 50% –±–Њ–ї—М—И–µ, –љ–µ–ґ–µ–ї–Є —З–µ–Љ –≤ –њ–Њ—Б–ї–µ–і–љ–Є–µ –і–љ–Є. –°–µ–≥–Њ–і–љ—П, 27 –љ–Њ—П–±—А—П, –њ–Њ—Б–µ—Й–∞–µ–Љ–Њ—Б—В—М –Њ—Б—В–∞—С—В—Б—П –љ–∞ –і–Њ—Б—В–Є–≥–љ—Г—В–Њ–Љ —Г—А–Њ–≤–љ–µ, –∞ –≥–ї—Г–±–Є–љ–∞ –њ—А–Њ—Б–Љ–Њ—В—А–∞ –µ—Й—С –љ–µ–Љ–љ–Њ–≥–Њ –њ–Њ–і—А–Њ—Б–ї–∞ –Є —Б–µ–є—З–∞—Б —Б–Њ—Б—В–∞–≤–ї—П–µ—В 1,95.

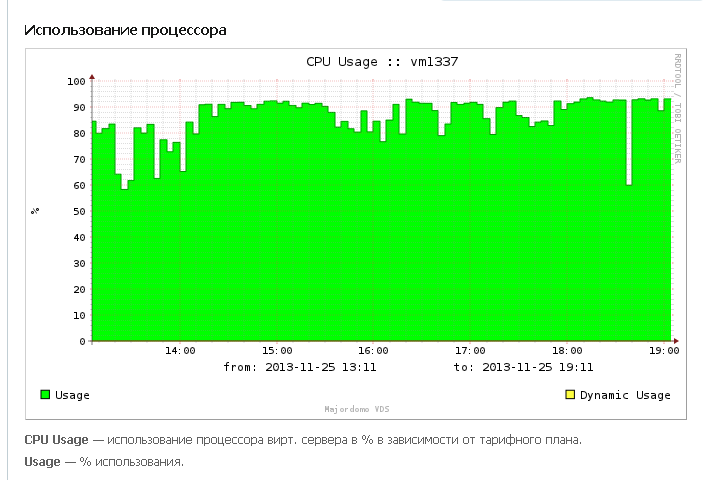

–Ґ–∞–Ї–∞—П –≤—Л—Б–Њ–Ї–∞—П –њ–Њ—Б–µ—Й–∞–µ–Љ–Њ—Б—В—М –љ–µ –њ—А–Њ—И–ї–∞ –±–µ—Б—Б–ї–µ–і–љ–Њ –і–ї—П —Б–µ—А–≤–µ—А–∞: –Њ–≥—А–Њ–Љ–љ–Њ–≥–Њ —В—А—Г–і–∞ —Г–і–∞–≤–∞–ї–Њ—Б—М –і–µ—А–ґ–∞—В—М –µ–≥–Њ –≤ —А–∞–±–Њ—З–µ–Љ —Б–Њ—Б—В–Њ—П–љ–Є–Є, –∞ –Њ–љ –њ–Њ—Б—В–Њ—П–љ–љ–Њ —Б—В—А–µ–Љ–Є–ї—Б—П —Г–њ–∞—Б—В—М –Є –Є—Б–њ—Г—Б—В–Є—В—М –і—Г—Е. –Э–Њ—З—М—О —Г –љ–µ–≥–Њ –≤—Б—С –ґ–µ —Б–ї—Г—З–Є–ї—Б—П –њ—А–Є—Б—В—Г–њ, –љ–∞–Ј–≤–∞–љ–љ—Л–є —В–µ—Е–њ–Њ–і–і–µ—А–ґ–Ї–Њ–є Kernel Panic –Є —Б 6 –і–Њ 8 —Г—В—А–∞ –њ–Њ –Ь–°–Ъ —Б–µ—А–≤–µ—А –±—Л–ї –≤ –∞—Г—В–µ. –Т–≤–Є–і—Г —В–∞–Ї–Є—Е —В—А—Г–і–љ–Њ—Б—В–µ–є –±—Л–ї–Є —А–∞—Б—Б–Љ–Њ—В—А–µ–љ—Л —Б–ї–µ–і—Г—О—Й–Є–µ –≤–∞—А–Є–∞–љ—В—Л:

–Т–Є—А—Г—Б—Л –љ–∞ —Б–µ—А–≤–µ—А–µ, –Ї–∞–Ї –љ–∞–є—В–Є –Є —Г–і–∞–ї–Є—В—М?

–Т–Є—А—Г—Б—Л –љ–∞ —Б–µ—А–≤–µ—А–µ –≤—Л–≥–ї—П–і—П—В –Ї–∞–Ї .php —Д–∞–є–ї—Л —Б —А–∞–Ј–љ—Л–Љ–Є –Є–Љ–µ–љ–∞–Љ–Є, –љ–∞—Е–Њ–і—П—Й–Є–µ—Б—П –≤ —А–∞–Ј–љ—Л—Е –і–Є—А–µ–Ї—В–Њ—А–Є—П—Е –Є –љ–µ—Б—Г—Й–Є–µ –≤–Є—А—Г—Б–љ—Л–є –Ї–Њ–і. –Я—А–Њ–љ–Є–Ї–∞—О—В –Њ–љ–Є —В—Г–і–∞ —Б –Ј–∞—А–∞–ґ–µ–љ–љ—Л—Е –Ї–Њ–Љ–њ—М—О—В–µ—А–Њ–≤, —Б –Ї–Њ—В–Њ—А—Л—Е –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В—Б—П –∞–і–Љ–Є–љ–Є—Б—В—А–Є—А–Њ–≤–∞–љ–Є–µ —Б–Є—Б—В–µ–Љ—Л –Є –њ–Њ—Б—А–µ–і—Б—В–≤–Њ–Љ —Г—П–Ј–≤–Є–Љ–Њ—Б—В–µ–є –Ї–∞–Ї –≤ CMS —Б–∞–є—В–∞, —В–∞–Ї –Є –≤ –Њ–±–Њ–ї–Њ—З–Ї–µ —Б–µ—А–≤–µ—А–∞. –Т –Љ–Њ—С–Љ —Б–ї—Г—З–∞–µ –њ–Њ–њ–∞–і–∞–ї–Є—Б—М —Б–ї–µ–і—Г—О—Й–Є–µ —В–Є–њ—Л –≤–Є—А—Г—Б–Њ–≤:

–Ч–∞—А–∞–ґ–µ–љ–љ—Л–µ —Д–∞–є–ї—Л .htaccess –Є phpinfo.php –≤–Њ –≤—Б–µ—Е —Б—В–∞–љ–і–∞—А—В–љ—Л—Е –њ–∞–њ–Ї–∞—Е joomla - –≤ images/stories, –≤ components/, –≤ language/ru-RU –Є —В.–і. –†–∞–Ј–Љ–µ—А —Д–∞–є–ї–∞ .htaccess —Б–Њ—Б—В–∞–≤–ї—П–ї 1642 –±–∞–є—В–∞ –Є —Б–Њ–і–µ—А–ґ–∞–ї –њ—А–Њ—Ж–µ–і—Г—А—Г –≤—Л–Ј–Њ–≤–∞ phpinfo.php –ї—О–±—Л–Љ –Ј–∞—И–µ–і—И–Є–Љ –±–Њ—В–Њ–Љ, –≤ —В–Њ–Љ —З–Є—Б–ї–µ googlebot. –§–∞–є–ї phpinfo.php –≤–µ—Б–Є–ї 5108 –±–∞–є—В –Є —Б–Њ–і–µ—А–ґ–∞–ї –Ї–Њ–і –≤–Є—А—Г—Б–∞, –Є—Б–њ–Њ–ї—М–Ј—Г—О—Й–µ–≥–Њ —Г—П–Ј–≤–Є–Љ–Њ—Б—В–Є base64_decode.

–Ч–∞—А–∞–ґ–µ–љ–љ—Л–µ —Д–∞–є–ї—Л —Б –њ—А–Њ–Є–Ј–≤–Њ–ї—М–љ—Л–Љ –Є–Љ–µ–љ–µ–Љ —В–Є–њ–∞ 4sdgf5.php, —Б–Њ–і–µ—А–ґ–∞—Й–Є–µ –Ї–Њ–і –≤–Є—А—Г—Б–∞.

–§–∞–є–ї—Л mailer.php, —Б–Њ–і–µ—А–ґ–∞—Й–Є–µ, –Ї–∞–Ї —П—Б–љ–Њ –Є–Ј –љ–∞–Ј–≤–∞–љ–Є—П, —Б–Ї—А–Є–њ—В —Б–њ–∞–Љ–±–Њ—В–∞

–Ф—А—Г–≥–Є–µ —Д–∞–є–ї—Л —Б –≤–Є—А—Г—Б–∞–Љ–Є, —Б–њ—А—П—В–∞–љ–љ—Л–µ –њ–Њ–і –Љ–Є—А–љ—Л–µ .png –Є–ї–Є .gif –Ї–∞—А—В–Є–љ–Ї–Є.

–Э–∞–є—В–Є –Є —Г–і–∞–ї–Є—В—М –≤–Є—А—Г—Б—Л –љ–∞ —Б–µ—А–≤–µ—А–µ —Г–і–∞–ї–Њ—Б—М —В–Њ–ї—М–Ї–Њ –≤—А—Г—З–љ—Г—О. –Я—А–Є –њ—А–Њ—Б–Љ–Њ—В—А–µ –і–Є—А–µ–Ї—В–Њ—А–Є–є –±—Л–ї–∞ –≤—Л—П–≤–ї–µ–љ–∞ –Ј–∞–Ї–Њ–љ–Њ–Љ–µ—А–љ–Њ—Б—В—М: –љ–µ–Ї–Њ—В–Њ—А—Л–µ —Д–∞–є–ї—Л –Є–Љ–µ–ї–Є –Њ—В–ї–Є—З–љ—Г—О –Њ—В –Њ—Б—В–∞–ї—М–љ—Л—Е –і–∞—В—Г —Б–Њ–Ј–і–∞–љ–Є—П, –≤–ї–∞–і–µ–ї—М—Ж–∞ –Є –љ–∞–±–Њ—А –њ—А–∞–≤. –Х—Б–ї–Є –≤—Б–µ –љ–Њ—А–Љ–∞–ї—М–љ—Л–µ —Д–∞–є–ї—Л –±—Л–ї–Є —Б–Њ–Ј–і–∞–љ—Л –≤ —П–љ–≤–∞—А–µ —Б–µ–≥–Њ –≥–Њ–і–∞, –Є–Љ–µ–ї–Є –∞–≤—В–Њ—А–∞ root –Є –њ—А–∞–≤–∞ 755, —В–Њ –≤–Є—А—Г—Б–љ—Л–µ —Д–∞–є–ї—Л –±—Л–ї–Є —Б–Њ–Ј–і–∞–љ—Л 6 –љ–Њ—П–±—А—П, –∞–≤—В–Њ—А–Њ–Љ –Є–Љ–µ–ї–Є apache –Є –њ—А–∞–≤–∞ –љ–Њ—Б–Є–ї–Є 644. –§–∞–є–ї—Л –≤–Є—А—Г—Б–Њ–≤ –љ–µ—Й–∞–і–љ–Њ —Г–і–∞–ї—П–ї–Є—Б—М, —В–∞–Ї –Ї–∞–Ї –љ–µ –њ–Њ–ї–Њ–ґ–µ–љ–Њ –±—Л—В—М —Д–∞–є–ї–∞–Љ .htaccess –Є .php –≤ —В–∞–Ї–Є—Е –њ–∞–њ–Ї–∞—Е, –Ї–∞–Ї images !!!

–Я–Њ–Љ–Њ–≥–ї–Њ –Є –ї–Њ–Ї–∞–ї—М–љ–Њ–µ —Б–Ї–∞–љ–Є—А–Њ–≤–∞–љ–Є–µ —Б–і–µ–ї–∞–љ–љ–Њ–≥–Њ –љ–Њ—З—М—О –±—Н–Ї–∞–њ–∞ –і–∞–љ–љ—Л—Е –∞–љ—В–Є–≤–Є—А—Г—Б–Њ–Љ Avast Internet Sequrity 8. –Ю–љ –љ–∞—И—С–ї –љ–µ –≤—Б–µ –≤–Є—А—Г—Б—Л –≤ –±—Н–Ї–∞–њ–µ, –љ–Њ —Г–Ї–∞–Ј–∞–ї, —З—В–Њ –Є–Љ–µ–љ–љ–Њ —Б—В–Њ–Є—В –Є—Б–Ї–∞—В—М –љ–∞ —Б–µ—А–≤–µ—А–µ.

–Я–Њ—Б–ї–µ –Є–Ј–ї–µ—З–µ–љ–Є—П —Б–µ—А–≤–µ—А–∞ –Њ—В –≤–Є—А—Г—Б–Њ–≤ –Є –Ј–∞–Ї—А—Л—В–Є—П –Є–Љ –і–∞–ї—М–љ–µ–є—И–µ–є –і–Њ—А–Њ–≥–Є –љ–∞ –љ–µ–≥–Њ –њ—А–Є—И–ї–Њ –љ–µ–Ї–Њ—В–Њ—А–Њ–µ –Њ–±–ї–µ–≥—З–µ–љ–Є–µ, –љ–Њ –і–ї–Є–ї–Њ—Б—М –Њ–љ–Њ –љ–µ–і–Њ–ї–≥–Њ –Є —Б–µ—А–≤–µ—А —Б–љ–Њ–≤–∞ –љ–∞—З–∞–ї –њ–Њ–і–∞–≤–∞—В—М –њ—А–Є–Ј–љ–∞–Ї–Є —Е–∞–љ–і—А—Л: 95-97% –Ј–∞–≥—А—Г–Ј–Ї—Г –њ—А–Њ—Ж–µ—Б—Б–Њ—А–∞, –±–Њ–ї—М—И–Њ–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ–Њ –Ј–∞–њ—Г—Й–µ–љ–љ—Л—Е –њ—А–Њ—Ж–µ—Б—Б–Њ–≤ httpd –Є –Њ–±—Й—Г—О –≤—П–ї–Њ—Б—В—М –њ—А–Є –Њ—В–Ї—А—Л—В–Є–Є —Б–∞–є—В–∞, –∞ –≤ –љ–µ–Ї–Њ—В–Њ—А—Л–µ –Љ–Њ–Љ–µ–љ—В—Л –Є –Њ—В–Ї–∞–Ј –≤ –і–Њ—Б—В—Г–њ–µ –њ–Њ –њ—А–Є—З–Є–љ–µ –љ–µ–≥–Њ—В–Њ–≤–љ–Њ—Б—В–Є –±–∞–Ј—Л MySQL. –Ґ–µ—Е–њ–Њ–і–і–µ—А–ґ–Ї–∞ –≤—Л—Б–Ї–∞–Ј–∞–ї–∞ –њ—А–µ–і–њ–Њ–ї–Њ–ґ–µ–љ–Є–µ, —З—В–Њ —Н—В–Њ DDOS –Є —Б–Є–ї—Л –±—Л–ї–Є –±—А–Њ—И–µ–љ—Л –љ–∞ –±–Њ—А—М–±—Г —Б –љ–Є–Љ

–Ъ–∞–Ї –±–Њ—А–Њ—В—М—Б—П —Б DDOS –∞—В–∞–Ї–Њ–є –Є —З—В–Њ —В–∞–Ї–Њ–µ DDOS –≤–Њ–Њ–±—Й–µ?

DDOS - —Н—В–Њ –∞—В–∞–Ї–∞ –Є–Ј–≤–љ–µ. –Ь–Њ–≥—Г—В –Ј–∞–Ї–∞–Ј–∞—В—М –≤–∞—И —Б–∞–є—В –Є –≤ –µ–≥–Њ –і–≤–µ—А–Є –љ–∞—З–љ—С—В –ї–Њ–Љ–Є—В—М—Б—П —В–Њ–ї–њ–∞ —А–Њ–±–Њ—В–Њ–≤ —Б –Ї—Г—З–µ–є –њ—Г—Б—В—Л—Е –Ј–∞–њ—А–Њ—Б–Њ–≤, –Ї–Њ—В–Њ—А—Л–µ –Љ–Є–≥–Њ–Љ –њ–Њ–≤–µ—Б—П—В —Б–µ—А–≤–µ—А –Є –љ–µ –Њ—В–њ—Г—Б—В—П—В –µ–≥–Њ, –њ–Њ–Ї–∞ –љ–µ –Ј–∞–Ї–Њ–љ—З–Є—В—Б—П "–Њ–њ–ї–∞—З–µ–љ–љ—Л–є –њ–µ—А–Є–Њ–і". –Т —Н—В–Њ–Љ —Б–ї—Г—З–∞–µ –њ—А–µ–і–њ—А–Є–љ–Є–Љ–∞—В—М —З—В–Њ-—В–Њ –±–µ—Б–њ–Њ–ї–µ–Ј–љ–Њ, —Б–µ—А–≤–µ—А –≤—Л –≤—Б—С —А–∞–≤–љ–Њ –љ–µ –њ–Њ–і–љ–Є–Љ–Є—В–µ. –Э–Ю —Н—В–Њ—В —Б–ї—Г—З–∞–є - –Њ–і–Є–љ –љ–∞ –Љ–Є–ї–ї–Є–Њ–љ, —В–µ–Љ –±–Њ–ї–µ–µ –і–ї—П —В–∞–Ї–Њ–≥–Њ —Б–∞–є—В–∞, –Ї–∞–Ї stevsky.ru. –Ъ–∞–Ї–Њ–є –Ї —З—С—А—В—Г –Ј–∞–Ї–∞–Ј? –Ъ–Њ–Љ—Г –љ—Г–ґ–љ–Њ –≤–µ—И–∞—В—М —Б–∞–є—В, –њ–Њ—Б–≤—П—Й—С–љ–љ—Л–є –Ї–Њ–Љ–њ—М—О—В–µ—А–љ—Л–Љ –Є–≥—А–∞–Љ –Є –љ–Њ–≤–µ–љ—М–Ї–Є–Љ —Б–Љ–∞—А—В—Д–Њ–љ–∞–Љ, –љ–µ –Є–Љ–µ—О—Й–Є–є –Ї–Њ–Љ–Љ–µ—А—З–µ—Б–Ї–Є—Е —Ж–µ–ї–µ–є –Ї—А–Њ–Љ–µ –Ї–∞–Ї –Ј–∞—А–∞–±–Њ—В–Ї–∞ –љ–∞ —А–µ–Ї–ї–∞–Љ–µ?

–Я–Њ—Н—В–Њ–Љ—Г —П —Б–µ–ї –∞–љ–∞–ї–Є–Ј–Є—А–Њ–≤–∞—В—М –ї–Њ–≥–Є –Є –њ—А–Є—И—С–ї –Ї –Є–љ—В–µ—А–µ—Б–љ–Њ–Љ—Г –≤—Л–≤–Њ–і—Г: –≤—Б—О —Н—В—Г –љ–∞–≥—А—Г–Ј–Ї—Г –љ–∞ —Б–µ—А–≤–µ—А —Б–Њ–Ј–і–∞—О—В –Њ–±—Л—З–љ—Л–µ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–Є, –Ј–∞–≥–ї—П–і—Л–≤–∞—О—Й–Є–µ –љ–∞ —Б–∞–є—В –Є —З–Є—В–∞—О—Й–Є–µ —Б—В–∞—В—М–Є. –Ф–∞-–і–∞, –њ—А–Њ—Б—В–Њ –њ–Њ—Б–µ—В–Є—В–µ–ї–Є —Б–∞–є—В–∞! –Э–Є–Ї–∞–Ї–Є—Е –∞—В–∞–Ї!

–Ъ–∞–Ї –ґ–µ —В–∞–Ї? –Э–µ—Г–ґ–µ–ї–Є –Љ–Њ—Й–љ—Л–є —Б–µ—А–≤–µ—А –љ–µ –Љ–Њ–ґ–µ—В —Б–њ—А–∞–≤–Є—В—М—Б—П —Б –њ–Њ—В–Њ–Ї–Њ–Љ –Є–Ј 10000 –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є –≤ —Б—Г—В–Ї–Є? –Ю–Ї–∞–Ј—Л–≤–∞–µ—В—Б—П, –љ–µ –Љ–Њ–ґ–µ—В. –Х—Б–ї–Є –љ–µ –≤—Л–њ–Њ–ї–љ–µ–љ —А—П–і –і–µ–є—Б—В–≤–Є–є –њ–Њ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є –Њ—В–і–∞—З–Є –Ї–Њ–љ—В–µ–љ—В–∞.

–Э–∞–њ—А–Є–Љ–µ—А, —А–∞–љ–µ–µ —Б—В–∞—В—М—П 4 —Д–Њ—В–Ї–Є 1 —Б–ї–Њ–≤–Њ —Б–Њ–і–µ—А–ґ–∞–ї–∞ –Т–°–Х –Њ—В–≤–µ—В—Л –љ–∞ –Њ–і–љ–Њ–є —Б—В—А–∞–љ–Є—Ж–µ! –Ґ–Њ –µ—Б—В—М –њ—А–Є –Ј–∞—Е–Њ–і–µ –љ–∞ –љ–µ—С –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М —Б—А–∞–Ј—Г –≥—А—Г–Ј–Є–ї –≤—Б–µ 410 –Ї–∞—А—В–Є–љ–Њ–Ї –Њ–±—Й–Є–Љ –≤–µ—Б–Њ–Љ –Њ–Ї–Њ–ї–Њ 20 –Љ–µ–≥–∞–±–∞–є—В, –∞ –њ–Њ—Б–µ—Й–∞–ї–∞—Б—М —Б—В–∞—В—М—П –Њ—З–µ–љ—М –і–∞–ґ–µ —З–∞—Б—В–Њ! –Я—А–Є—И–ї–Њ—Б—М —А–∞–Ј–±–Є–≤–∞—В—М —Б—В–∞—В—М—О –љ–∞ 8 —З–∞—Б—В–µ–є, –њ–Њ 50 –Ї–∞—А—В–Є–љ–Њ–Ї –≤ –Ї–∞–ґ–і–Њ–є, –Є –Ј–∞—Б—В–∞–≤–ї—П—В—М –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є —А—Л—Б–Ї–∞—В—М –њ–Њ –≤—Б–µ–Љ —З–∞—Б—В—П–Љ –≤ –њ–Њ–Є—Б–Ї–∞—Е –Њ—В–≤–µ—В–∞ –љ–∞ –Є—Е –≤–Њ–њ—А–Њ—Б. –≠—В–Њ, –њ—А–∞–≤–і–∞, –њ—А–Є–љ–µ—Б–ї–Њ —Б—В–Њ–ї—М –ґ–µ–ї–∞–љ–љ–Њ–µ —Г–≤–µ–ї–Є—З–µ–љ–Є–µ –≥–ї—Г–±–Є–љ—Л –њ—А–Њ—Б–Љ–Њ—В—А–∞ –Є –Њ–±—Й–µ–≥–Њ –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ –њ—А–Њ—Б–Љ–Њ—В—А–Њ–≤, –∞ —В–∞–Ї–ґ–µ —Б–љ–Є–Ј–Є–ї–Њ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –Њ–і–љ–Њ–≤—А–µ–Љ–µ–љ–љ—Л—Е –Ј–∞–≥—А—Г–Ј–Њ–Ї .jpg —Д–∞–є–ї–Њ–≤ –Є–Ј —Н—В–Њ–є –і–Є—А–µ–Ї—В–Њ—А–Є–Є. –Т —Ж–µ–ї—П—Е —Б–Њ–Ї—А–∞—Й–µ–љ–Є—П —В—А–∞—Д–Є–Ї–∞ –Ї–∞—А—В–Є–љ–Ї–Є —В–∞–Ї–ґ–µ –±—Л–ї–Є –њ–µ—А–µ–ґ–∞—В—Л —Б –љ–µ–Ј–љ–∞—З–Є—В–µ–ї—М–љ–Њ–є –њ–Њ—В–µ—А–µ–є –Ї–∞—З–µ—Б—В–≤–∞ –Є —Б—Г–Љ–Љ–∞—А–љ–Њ –њ–Њ—Е—Г–і–µ–ї–Є –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є –≤–і–≤–Њ–µ, –і–Њ 10–Ь–С.

–Ґ–∞ –ґ–µ –Њ–њ–µ—А–∞—Ж–Є—П –±—Л–ї–∞ –њ—А–Њ–≤–µ–і–µ–љ–∞ —Б–Њ —Б—В–∞—В—М—С–є –І—В–Њ –Ј–∞ —Б–ї–Њ–≤–Њ - –Њ—В–≤–µ—В—Л –Ї –Є–≥—А–µ –љ–∞ –∞–љ–і—А–Њ–Є–і, 302 –Ї–∞—А—В–Є–љ–Ї–Є –±—Л–ї–Є —А–∞–Ј–±–Є—В—Л –љ–∞ 6 —Б—В–∞—В–µ–є.

–°–µ—А–≤–µ—А—Г –Ј—А–Є–Љ–Њ –њ–Њ–ї–µ–≥—З–∞–ї–Њ, –љ–Њ –≤—Б—С –ґ–µ –Њ–љ –µ—Й—С –Љ–Њ–≥ –њ–µ—А–µ–≥—А–µ—В—М—Б—П. –Ш —П –њ–µ—А–µ—И—С–ї –Ї —В—П–ґ—С–ї–Њ–є –∞—А—В–Є–ї–ї–µ—А–Є–Є

–Я–Њ–Є—Б–Ї–Њ–≤—Л–µ –±–Њ—В—Л –љ–∞–≥—А—Г–ґ–∞—О—В —Б–µ—А–≤–µ—А, —З—В–Њ –і–µ–ї–∞—В—М?

–Ы–Њ–≥–Є - –њ—А–µ–Ї—А–∞—Б–љ–∞—П –≤–µ—Й—М, –Ї–Њ–≥–і–∞ —Г–Љ–µ–µ—И—М –Є—Е —З–Є—В–∞—В—М. –ѓ –љ–Є —З–µ—А—В–∞ –љ–µ –њ–Њ–љ–Є–Љ–∞—О –≤ –ї–Њ–≥–∞—Е, –њ–Њ—Н—В–Њ–Љ—Г –њ—А–Є—И–ї–Њ—Б—М –і–Њ–ї–≥–Њ —Б–Є–і–µ—В—М –Є —А–∞–Ј–±–Є—А–∞—В—М—Б—П. –Ю–Ї–∞–Ј—Л–≤–∞–µ—В—Б—П, –±—Л—Б—В—А–∞—П –Є–љ–і–µ–Ї—Б–∞—Ж–Є—П —Б–∞–є—В–∞ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–∞–Љ–Є –Є–Љ–µ–µ—В –Њ–±—А–∞—В–љ—Г—О —Б—В–Њ—А–Њ–љ—Г: –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —А–Њ–±–Њ—В—Л –Њ—Б—Г—Й–µ—Б—В–≤–ї—П—О—В —З—Г–і–Њ–≤–Є—Й–љ—Г—О –љ–∞–≥—А—Г–Ј–Ї—Г –љ–∞ —Б–µ—А–≤–µ—А! –Ш—Е —В—А–∞—Д–Є–Ї —Б–Њ—Б—В–∞–≤–ї—П–µ—В –Њ—В 30% –і–Њ 80% –Њ–±—Й–µ–≥–Њ —В—А–∞—Д–Є–Ї–∞ —Б–µ—А–≤–µ—А–∞ –Є –Є–Љ–µ–љ–љ–Њ –Њ–љ–Є —П–≤–ї—П—О—В—Б—П –њ—А–Є—З–Є–љ–Њ–є –Љ–µ–і–ї–µ–љ–љ–Њ–є —А–∞–±–Њ—В—Л —Б–∞–є—В–∞, –Ј–∞–≤–Є—Б–∞–љ–Є–є, –њ–∞–і–µ–љ–Є–є –Є –≤—Б—П–Ї–Є—Е —В–∞–Љ Kernel Panic. –Ъ–µ—А–љ–µ–ї—М –њ—А–Њ—Б—В–Њ –≤ –њ–∞–љ–Є–Ї–µ –Њ—В –Є—Е –љ–∞–≥–ї–Њ—Б—В–Є –Є –њ—А–Њ–ґ–Њ—А–ї–Є–≤–Њ—Б—В–Є!

–Ю–≥—А–∞–љ–Є—З–Є–≤–∞—В—М –±–Њ—В–Њ–≤ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ –Є —З–µ–Љ –ґ—С—Б—В—З–µ –≤—Л —Б –љ–Є–Љ–Є –±—Г–і–µ—В–µ, —В–µ–Љ –±—Л—Б—В—А–µ–µ –њ–Њ–ї–µ–≥—З–∞–µ—В –≤–∞—И–µ–Љ—Г —Б–µ—А–≤–µ—А—Г!

–Ч–∞–Ї—А—Л—В—М –њ–∞–њ–Ї–Є –Њ—В –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е –±–Њ—В–Њ–≤

–Ф–ї—П —Н—В–Њ–≥–Њ –љ–∞–Љ –љ—Г–ґ–љ–Њ –њ—А–∞–≤–Є—В—М —Д–∞–є–ї robots.txt, –љ–Њ –њ—А–∞–≤–Є—В—М –µ–≥–Њ —Г–Љ–љ–Њ. –Т–Њ—В, –љ–∞–њ—А–Є–Љ–µ—А, —З—В–Њ –њ–Њ–ї—Г—З–Є–ї–Њ—Б—М —Г –Љ–µ–љ—П:

User-agent: *

Disallow: /administrator/

Disallow: /arhiv/

Disallow: /cache/

Disallow: /components/

Disallow: /images/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Disallow: /xmlrpc/

Disallow: /cgi-bin/

Disallow: /ckeditor/

Disallow: /error/

Disallow: /logs/

Disallow: /music/

Disallow: /stats/

Disallow: /webstat/

Disallow: /index2.php?option=com_content&task=emailform

Disallow: /*?sl*

Disallow: *.pdf$

Disallow: /name.php?action=print

Disallow: /trackback

Disallow: /*rss.html

Disallow: /*atom.html

Crawl-delay: 5

Host: www.stevsky.ru

sitemap: /index.php?option=com_xmap&sitemap=2&view=xml

–ѓ –Ј–∞–±–ї–Њ–Ї–Є—А–Њ–≤–∞–ї –Т–°–Х–Ь –±–Њ—В–∞–Љ –Т–°–Х –њ–∞–њ–Ї–Є –Љ–Њ–µ–≥–Њ —Б–∞–є—В–∞! –Ф–∞–ґ–µ images, –њ–ї—О–љ—Г–≤ –љ–∞ —В–Њ, —З—В–Њ –≤ —Н—В–Њ–Љ —Б–ї—Г—З–∞–µ —Б–∞–є—В –љ–µ –±—Г–і–µ—В —Г—З–∞—Б—В–≤–Њ–≤–∞—В—М –≤ –њ–Њ–Є—Б–Ї–µ –њ–Њ –Ї–∞—А—В–Є–љ–Ї–∞–Љ. –Ф–∞ –Ї–Њ–Љ—Г –Њ–љ –љ–∞—Е—А–µ–љ –љ—Г–ґ–µ–љ, —Н—В–Њ—В –њ–Њ–Є—Б–Ї –њ–Њ –Ї–∞—А—В–Є–љ–Ї–∞–Љ? –£ –Љ–µ–љ—П —Б –љ–µ–≥–Њ –Є–Ј 170—В—Л—Б. –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є –≤ –Љ–µ—Б—П—Ж –њ—А–Є—И–ї–Њ —З—В–Њ-—В–Њ –Њ–Ї–Њ–ї–Њ —Б–Њ—В–љ–Є! –Т —Б–ї–µ–і—Г—О—Й–µ–Љ –Љ–µ—Б—П—Ж–µ —П –ї–µ–≥–Ї–Њ –њ–µ—А–µ–ґ–Є–≤—Г –Є –±–µ–Ј –љ–Є—Е!

–Я–Њ—Б–ї–µ —В–Њ–≥–Њ, –Ї–∞–Ї –Ј–∞–±–ї–Њ–Ї–Є—А–Њ–≤–∞–ї–Є –≤—Б–µ –њ–∞–њ–Ї–Є, –Ј–∞–±–ї–Њ–Ї–Є—А—Г–µ–Љ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –Њ—В–њ—А–∞–≤–Ї–Є –њ–Њ—З—В—Л —Б —Б–∞–є—В–∞ emailform, —З—В–µ–љ–Є—П pdf —Д–∞–є–ї–Њ–≤ –љ–∞–њ—А—П–Љ—Г—О, –Є–љ–і–µ–Ї—Б–∞—Ж–Є—О rss –Є atom —Д–Є–і–Њ–≤.

Crawl-delay - —Н—В–Њ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ —Б–µ–Ї—Г–љ–і –Љ–µ–ґ–і—Г –Є–љ–і–µ–Ї—Б–∞—Ж–Є–µ–є –і–≤—Г—Е —Б—В—А–∞–љ–Є—Ж. –С–Њ—В –Ј–∞–Ї–∞–љ—З–Є–≤–∞–µ—В –Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М –њ–µ—А–≤—Г—О —Б—В—А–∞–љ–Є—Ж—Г, –ґ–і—С—В –њ—П—В—М —Б–µ–Ї—Г–љ–і –Є —В–Њ–ї—М–Ї–Њ –њ–Њ—В–Њ–Љ –љ–∞—З–Є–љ–∞–µ—В –Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М –≤—В–Њ—А—Г—О. –Ф–∞, –Є–љ–і–µ–Ї—Б–∞—Ж–Є—П –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –Ј–∞–Љ–µ–і–ї–Є—В—Б—П –Є –Љ–Њ–Є 3000 —Б—В—А–∞–љ–Є—Ж (–Њ—В–Ї—Г–і–∞ —П–љ–і–µ–Ї—Б —Б—В–Њ–ї—М–Ї–Њ –љ–∞–±—А–∞–ї, —Г–Љ—Г –љ–µ –њ—А–Є–ї–Њ–ґ—Г!) —В–µ–њ–µ—А—М –±—Г–і—Г—В –Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М—Б—П –љ–∞ 15000 —Б–µ–Ї—Г–љ–і (–Њ–Ї–Њ–ї–Њ 4 —З–∞—Б–Њ–≤) –і–Њ–ї—М—И–µ, –љ–Њ –≤–µ–і—М –љ–µ –Ї–∞–ґ–і—Л–є –ґ–µ –і–µ–љ—М —П–љ–і–µ–Ї—Б–±–Њ—В —Г—Б—В—А–∞–Є–≤–∞–µ—В –≥–ї–Њ–±–∞–ї—М–љ—Г—О –њ–µ—А–µ–њ—А–Њ–≤–µ—А–Ї—Г –Љ–Њ–µ–≥–Њ —Б–∞–є—В–∞! –Ґ–∞–Ї —З—В–Њ —Н—В–Њ –≤–Њ–≤—Б–µ –љ–µ–Ї—А–Є—В–Є—З–љ–Њ, –∞ —А–µ—Б—Г—А—Б—Л —Б–µ—А–≤–µ—А–∞ –Љ–Њ–ґ–љ–Њ –Ј–∞–Љ–µ—В–љ–Њ —Б—Н–Ї–Њ–љ–Њ–Љ–Є—В—М!

–Ч–∞–њ—А–µ—В–Є—В—М –љ–µ—Г–≥–Њ–і–љ—Л—Е –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е –±–Њ—В–Њ–≤

–Э–µ –≤—Б–µ –±–Њ—В—Л —Е–Њ—А–Њ—И–Є, –љ–µ –≤—Б–µ –Њ–љ–Є –љ—Г–ґ–љ—Л. –Я–Њ –±–Њ–ї—М—И–Њ–Љ—Г —Б—З—С—В—Г, –і–ї—П –Ї–∞—З–µ—Б—В–≤–µ–љ–љ–Њ–є –Є–љ–і–µ–Ї—Б–∞—Ж–Є–Є —Б–∞–є—В–∞ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –≤—Б–µ–≥–Њ —З–µ—В—Л—А–µ –±–Њ—В–∞: yandex, googlebot, mailru –Є rambler. –Я—А–Є—З—С–Љ –њ–Њ—Б–ї–µ–і–љ–Є–µ –і–≤–∞ –≤–љ–Њ—Б—П—В –ї–Є—И—М –ґ–∞–ї–Ї–Є–µ 2,5% –≤ –Њ–±—Й–Є–є –Ї–Њ—В—С–ї, —В–∞–Ї —З—В–Њ –Є –Њ—В –љ–Є—Е –Љ–Њ–ґ–љ–Њ –Њ—В–Ї–∞–Ј–∞—В—М—Б—П. –Ю—Б—В–∞–ї—М–љ—Л—Е - –Ј–∞–Ї—А—Л—В—М, –Ј–∞–њ—А–µ—В–Є—В—М, –Њ—В–Ї–ї—О—З–Є—В—М –Є –њ–Њ—Б–ї–∞—В—М –Ї —З—С—А—В–Њ–≤–Њ–є –±–∞–±—Г—И–Ї–µ, –њ–Њ—В–Њ–Љ—Г –Ї–∞–Ї –Њ–љ–Є –Љ–Њ–≥—Г—В –Ї–∞–Ї –њ—А–Њ—Б—В–Њ –љ–∞–Ј–Њ–є–ї–Є–≤–Њ –≥—А—Г–Ј–Є—В—М —Б–µ—А–≤–µ—А, —В–∞–Ї –Є –Ј–∞–Ї–Є–і—Л–≤–∞—В—М –µ–≥–Њ –њ–∞—З–Ї–∞–Љ–Є –љ–µ–љ—Г–ґ–љ—Л—Е –Ј–∞–њ—А–Њ—Б–Њ–≤, —Г–≤–µ–ї–Є—З–Є–≤–∞—П –Њ–±—К—С–Љ —В—А–∞—Д–Є–Ї–∞ –Є –≤ –Ї—А–Є—В–Є—З–µ—Б–Ї–Є—Е —Б–Є—В—Г–∞—Ж–Є—П—Е –≤–µ—И–∞—П –љ–∞–њ—А–Њ—З—М. –Т–Њ—В —В–∞–Ї–Њ–є —Б–њ–Є—Б–Њ–Ї –Љ–Њ–ґ–љ–Њ –≤–љ–µ—Б—В–Є –≤ –≤–∞—И —Д–∞–є–ї .htaccess:

########## –С–ї–Њ–Ї–Є—А—Г–µ–Љ –љ–µ—Г–≥–Њ–і–љ—Л—Е –±–Њ—В–Њ–≤

order allow,deny

allow from all

# –Ф–∞–ї–µ–µ —Б–њ–Є—Б–Њ–Ї –±–Њ—В–Њ–≤, –Ї–Њ—В–Њ—А—Л–Љ –Љ—Л –Ј–∞–њ—А–µ—Й–∞–µ–Љ –і–Њ—Б—В—Г–њ

SetEnvIfNoCase User-Agent JS-Kit bad_bot

SetEnvIfNoCase User-Agent PostRank bad_bot

SetEnvIfNoCase User-Agent Python-urllib bad_bot

SetEnvIfNoCase User-Agent UnwindFetchor bad_bot

SetEnvIfNoCase User-Agent facebookexternalhit bad_bot

SetEnvIfNoCase User-Agent TweetmemeBot bad_bot

SetEnvIfNoCase User-Agent Butterfly bad_bot

SetEnvIfNoCase User-Agent MFE_expand bad_bot

SetEnvIfNoCase User-Agent Java bad_bot

SetEnvIfNoCase User-Agent Summify bad_bot

SetEnvIfNoCase User-Agent MetaURI bad_bot

SetEnvIfNoCase User-Agent FlipboardProxy bad_bot

SetEnvIfNoCase User-Agent ScribdReader bad_bot

SetEnvIfNoCase User-Agent RockMelt bad_bot

SetEnvIfNoCase User-Agent InAGist bad_bot

SetEnvIfNoCase User-Agent NING bad_bot

SetEnvIfNoCase User-Agent TweetedTimes bad_bot

SetEnvIfNoCase User-Agent PaperLiBot bad_bot

SetEnvIfNoCase User-Agent Library bad_bot

SetEnvIfNoCase User-Agent Ezooms bad_bot

SetEnvIfNoCase User-Agent strawberryj bad_bot

SetEnvIfNoCase User-Agent Scooper bad_bot

SetEnvIfNoCase User-Agent Ahrefs bad_bot

SetEnvIfNoCase User-Agent Spider bad_bot

SetEnvIfNoCase User-Agent None bad_bot

SetEnvIfNoCase User-Agent EventMachine bad_bot

SetEnvIfNoCase User-Agent aiHitBot bad_bot

SetEnvIfNoCase User-Agent SolomonoBot bad_bot

SetEnvIfNoCase User-Agent SearchBot bad_bot

SetEnvIfNoCase User-Agent Wget bad_bot

SetEnvIfNoCase User-Agent Crawler bad_bot

Order Allow,Deny

Allow from all

Deny from env=bad_bot

–Я—А–∞–≤–і–∞, —Н—В–Њ—В —Б–њ–Є—Б–Њ–Ї –±–ї–Њ–Ї–Є—А—Г–µ—В –ї–Є—И—М –Є–Ј–±—А–∞–љ–љ—Л—Е "–њ–ї–Њ—Е–Є—Е –±–Њ—В–Њ–≤", —З—М—П –Ј–ї–Њ–≤—А–µ–і–љ–Њ—Б—В—М –±—Л–ї–∞ –Њ–±–љ–∞—А—Г–ґ–µ–љ–∞ –Є –њ–Њ–і—В–≤–µ—А–ґ–і–µ–љ–∞, –љ–Њ –Њ—Б—В–∞–≤–ї—П–µ—В –ї–∞–Ј–µ–є–Ї–Є –љ–Њ–≤—Л–Љ –Є –Љ–∞–ї–Њ–Є–Ј–≤–µ—Б—В–љ—Л–Љ –±–Њ—В–∞–Љ, –Ї–Њ—В–Њ—А—Л–µ –Љ–Њ–≥—Г—В –Њ–Ї–∞–Ј–∞—В—М—Б—П –µ—Й—С –±–Њ–ї–µ–µ –њ–∞–Ї–Њ—Б—В–љ—Л–Љ–Є. –Ю–і–љ–∞–Ї–Њ –Ї–∞—А–і–Є–љ–∞–ї—М–љ–∞—П –Љ–µ—А–∞ "–Њ—В–Ї–∞–Ј–∞—В—М –≤—Б–µ–Љ, –Ї—А–Њ–Љ–µ [—Б–њ–Є—Б–Њ–Ї]" –Љ–Њ–ґ–µ—В –њ—А–Є–≤–µ—Б—В–Є –Ї –њ—А–Њ–±–ї–µ–Љ–∞–Љ –Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞–љ–Є—П –≤ —Б–ї—Г—З–∞–µ –µ—Б–ї–Є —А–∞–Ј—А–µ—И–µ–љ–љ—Л–є –±–Њ—В —Б–Љ–µ–љ–Є—В –љ–∞–Ј–≤–∞–љ–Є–µ –Є–ї–Є –њ–Њ—П–≤–Є—В—Б—П –Ї–∞–Ї–Њ–є-—В–Њ –љ–Њ–≤—Л–є –Ї–∞—З–µ—Б—В–≤–µ–љ–љ—Л–є –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї (—З—В–Њ –Ї–Њ–љ–µ—З–љ–Њ –≤—А—П–і –ї–Є, –љ–Њ –≤—Б—С –ґ–µ), –њ–Њ—Н—В–Њ–Љ—Г –њ—А–µ–і–ї–∞–≥–∞—О –Њ—Б—В–∞–љ–Њ–≤–Є—В—М—Б—П –љ–∞ —В–∞–Ї–Њ–Љ –≤–∞—А–Є–∞–љ—В–µ. –°–њ–Є—Б–Њ–Ї —Б–Њ –≤—А–µ–Љ–µ–љ–µ–Љ –Љ–Њ–ґ–љ–Њ –њ–Њ–њ–Њ–ї–љ—П—В—М, —Г—Б–ї—Л—И–∞–≤ –Є–Љ—П –Њ—З–µ—А–µ–і–љ–Њ–≥–Њ –Ј–ї–Њ–њ–∞–Ї–Њ—Б—В–љ–Њ–≥–Њ –±–Њ—В–∞, –ї—О—В—Г—О—Й–µ–≥–Њ –љ–∞ –њ—А–Њ—Б—В–Њ—А–∞—Е –Є–љ—В–µ—А–љ–µ—В–∞, –Є–ї–Є –Њ—В—Б–ї–µ–і–Є–≤ –∞–љ–Њ–Љ–∞–ї—М–љ—Г—О –∞–Ї—В–Є–≤–љ–Њ—Б—В—М –≤ –ї–Њ–≥–∞—Е. –Ф–∞, —З–Є—В–∞—В—М –ї–Њ–≥–Є –њ—А–Є–і—С—В—Б—П —Г—З–Є—В—М—Б—П –≤ –ї—О–±–Њ–Љ —Б–ї—Г—З–∞–µ, —В–∞–Ї —З—В–Њ –Љ–Њ–ґ–µ—В–µ –њ—А–Є—Б—В—Г–њ–∞—В—М –њ—А—П–Љ–Њ —Б–µ–є—З–∞—Б...

–°–љ–Є–ґ–µ–љ–Є–µ –љ–∞–≥—А—Г–Ј–Ї–Є –љ–∞ —Б–µ—А–≤–µ—А

–Я—А–Є–љ—П—В—Л–µ –Љ–µ—А—Л –њ—А–Є–≤–µ–ї–Є –Ї —Б–љ–Є–ґ–µ–љ–Є—О –љ–∞–≥—А—Г–Ј–Ї–Є –љ–∞ —Б–µ—А–≤–µ—А –њ—А–Є–Љ–µ—А–љ–Њ –љ–∞ 50%, —З—В–Њ –њ–Њ–Ј–≤–Њ–ї–Є–ї–Њ –µ–Љ—Г –Є—Б–њ—А–∞–≤–љ–Њ —Д–љ–Ї—Ж–Є–Њ–љ–Є—А–Њ–≤–∞—В—М –Є –њ–µ—А–µ–≤–∞—А–Є–≤–∞—В—М –Њ–Ї–Њ–ї–Њ 20000 –њ—А–Њ—Б–Љ–Њ—В—А–Њ–≤ —Б—В—А–∞–љ–Є—Ж –≤ —Б—Г—В–Ї–Є. –Ъ–Њ–≥–і–∞ –њ–Њ—Б–µ—Й–∞–µ–Љ–Њ—Б—В—М –≤—Л—А–∞—Б—В–µ—В –µ—Й—С –≤ 1,5-2 —А–∞–Ј–∞, –њ—А–Є–і—С—В—Б—П –њ—А–µ–і–њ—А–Є–љ–Є–Љ–∞—В—М –і–∞–ї—М–љ–µ–є—И–Є–µ –Љ–µ—А—Л. –Ь–Њ–ґ–µ—В, –њ–µ—А–µ—Е–Њ–і–Є—В—М –љ–∞ –±–Њ–ї–µ–µ –Љ–Њ—Й–љ—Л–є —Б–µ—А–≤–µ—А, –∞ –Љ–Њ–ґ–µ—В –Њ—В–Ї—А—Л–≤–∞—В—М –і–ї—П —Б–µ–±—П —В–∞–є–љ—Л –Ї–Њ–љ—Д–Є–≥—Г—А–Є—А–Њ–≤–∞–љ–Є—П apache –≤ —Б–≤—П–Ј–Ї–µ —Б nginx.

–Я–Њ–Ї–∞ —З—В–Њ –Љ–µ–љ—П –њ–µ—А–µ–і—С—А–≥–Є–≤–∞–µ—В –Њ—В –Њ–і–љ–Њ–є –і–∞–ґ–µ –Љ—Л—Б–ї–Є, –≤ –Ї–∞–Ї–Є–µ –і–µ–±—А–Є –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є—П –Љ–љ–µ –њ—А–Є–і—С—В—Б—П –ї–µ–Ј—В—М, –≤–µ–і—М —П –љ–Є —З–µ—А—В–∞ –љ–µ —Б–Њ–Њ–±—А–∞–ґ–∞—О –≤ Linux, –љ–∞ –Ї–Њ—В–Њ—А–Њ–Љ —А–∞–±–Њ—В–∞–µ—В —Б–µ—А–≤–µ—А, —Б —В—А—Г–і–Њ–Љ –Њ—В–ї–Є—З–∞—О Apache –Њ—В Root –Є –Є–љ–Њ–≥–і–∞ –њ—Г—В–∞—О kernel —Б nginx. –Э–Њ, –Ї–∞–Ї –њ–Њ–Ї–∞–Ј—Л–≤–∞–µ—В –њ—А–∞–Ї—В–Є–Ї–∞, –і–Њ—А–Њ–≥—Г –Њ—Б–Є–ї–Є—В –Є–і—Г—Й–Є–є –Є —З–∞—Б—Л —Г–њ–Њ—А–љ–Њ–≥–Њ —А–∞–Ј–±–Є—А–∞—В–µ–ї—М—Б—В–≤–∞ –Є —З—В–µ–љ–Є—П –Љ–∞–љ—Г–∞–ї–Њ–≤ –і–∞—А—Г—О—В –Њ—В–Ї—А–Њ–≤–µ–љ–Є–µ!

| < –Я—А–µ–і—Л–і—Г—Й–∞—П | –°–ї–µ–і—Г—О—Й–∞—П > |

|---|

- 01/05/2014 - –Ґ–Ш–¶ 50, —Б–Њ—В–љ—П –°–Ь–Ш, 50—В—Л—Б. –њ—А–Њ—Б–Љ–Њ—В—А–Њ–≤ –≤ –і–µ–љ—М

- 16/04/2014 - –ѓ–љ–і–µ–Ї—Б –њ—А–Њ–Є–Ј–≤–µ–ї –Њ—В–Ї–ї—О—З–µ–љ–Є–µ —Б—Б—Л–ї–Њ—З–љ–Њ–≥–Њ —А–∞–љ–ґ–Є—А–Њ–≤–∞–љ–Є—П

- 06/02/2014 - –Я—А–∞–≤–Є–ї–∞ –њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П —Б–∞–є—В–Њ–Љ stevsky.ru

- 25/01/2014 - –Р–њ–і–µ–є—В –Ґ–Ш–¶ 24.01.2014

- 19/01/2014 - –≠—В–Њ—В –љ–Њ–≤—Л–є —Б—З–∞—Б—В–ї–Є–≤—Л–є 2014 –≥–Њ–і

- 01/01/2014 - –Ф–Њ—Б—В–Є–ґ–µ–љ–Є—П —Б–∞–є—В–∞ –Ј–∞ 2013 –≥–Њ–і

- 22/12/2013 - Google PR 2 –Є 4 –Ї–Њ–њ–Є—А–∞–є—В–µ—А–∞

- 13/11/2013 - –§–Є–Ї—Б–∞—Ж–Є—П 6000

- 11/11/2013 - 1000 —Б—В–∞—В–µ–є

- 05/11/2013 - –§–Є–Ї—Б–∞—Ж–Є—П 5000

- 27/10/2013 - 8000 –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є

- 21/10/2013 - –Э–µ–і–µ–ї—П –њ—А–Є–љ–µ—Б–ї–∞ –љ–Њ–≤—Л–µ —А–µ–Ї–Њ—А–і—Л - 7548 –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є –≤ —Б—Г—В–Ї–Є, 11110 –њ—А–Њ—Б–Љ–Њ—В—А–Њ–≤!

- 18/10/2013 - –Ъ–Њ–љ—В–µ–љ—В-–Љ–µ–љ–µ–і–ґ–µ—А

- 11/10/2013 - –†–µ–Ї–Њ—А–і –њ–Њ—Б–µ—Й–∞–µ–Љ–Њ—Б—В–Є - 5974 —З–µ–ї–Њ–≤–µ–Ї–∞ –≤ –і–µ–љ—М